Mais voilà : quand un groupe de chercheurs finit par comprendre quelque chose de nouveau, on peut exploiter cette connaissance de façon bénéfique ou néfaste.

On en est là : à ce moment charnière où la science de l’intelligence artificielle sort des labos d’universités. Depuis cinq ou six ans, les grandes entreprises comme Facebook et Google ont commencé à s’y intéresser au point de mettre des centaines de millions de dollars sur la table pour acheter des entreprises en IA, puis pour développer cette expertise à l’interne.

Depuis, la progression est exponentielle. Les entreprises sont très intéressées à utiliser ces connaissances afin de développer de nouveaux marchés et produits, d’améliorer leur efficacité, etc.

Or, à mesure que l’IA se déploie dans la société, il y a un impact. À nous de choisir comment les choses se feront. Le futur est entre nos mains.

Robots tueurs, pertes d’emplois, discrimination…

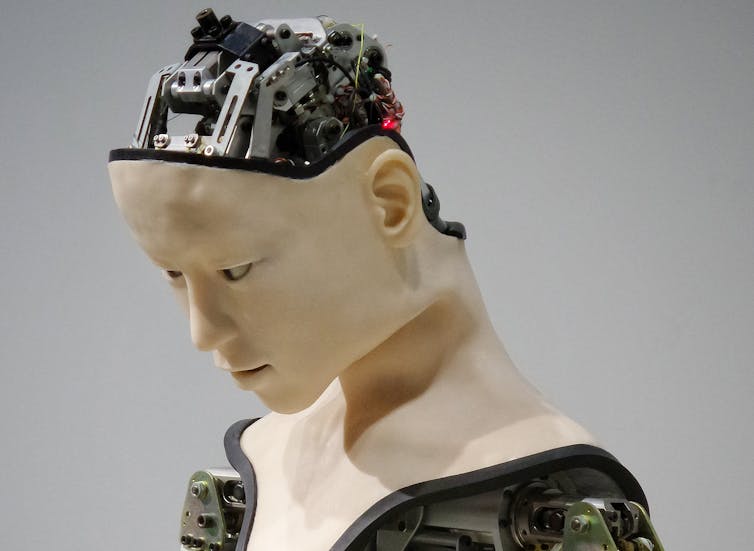

Dès le départ, l’enjeu qui a été identifié et qui m'a interpellé est celui des armes létales autonomes, aussi appelés les robots tueurs. Il y a à la fois une question morale — parce que les machines n'ont pas de compréhension du contexte humain, psychologique et moral — et une question de sécurité, parce que ces armes pourraient déstabiliser l'ordre mondial.

Un autre enjeu qui est vite apparu est celui des emplois perdus par l’automatisation. On a posé la question : pourquoi ? On veut soulager qui de quoi ? Le camionneur n’est pas heureux sur la route ? Il faut le remplacer par… personne ?

Nous, scientifiques, n’y pouvons pas grand-chose en apparence. Ce sont les forces du marché qui déterminent quels emplois vont être éliminés ou ceux dont la tâche sera réduite, selon l’efficacité économique des solutions de remplacement automatisées. Mais nous sommes aussi des citoyens qui peuvent participer d’une manière unique au débat social et politique sur ces enjeux à cause précisément de notre expertise.

Les informaticiens sont interpellés par l’enjeu des emplois. Non pas parce qu’ils vont en souffrir personnellement, c’est tout le contraire. Mais ils sentent qu’ils ont une responsabilité, et ne veulent pas que leur travail mette des millions de personnes potentiellement à la rue. Il y a donc un fort soutien parmi les informaticiens — et en particulier ceux du secteur de l’IA — pour une révision du filet social permettant une forme de revenu minimum garanti, ou je dirais une forme de dignité humaine garantie.

Le but de l’innovation technologique est de réduire la misère humaine, pas de l’augmenter.

Elle ne vise pas non plus à accroître la discrimination et les injustices. Et pourtant, l’IA peut y contribuer.

En fait, la discrimination n’est pas tant due au fait, comme on l’entend parfois, que l’IA a surtout été conçue par des hommes, en raison du manque effarant de femmes qui œuvrent dans les technologies. Mais surtout parce que l'IA est entraînée sur des données qui reflètent les comportements des gens. Et ces comportements sont malheureusement biaisés.

En d’autres termes, un système qui est entraîné sur des données qui viennent des comportements des gens aura les mêmes biais et discriminations que ces derniers. Il ne sera pas politically correct. Il ne va pas naturellement agir selon les idées morales de la société, mais selon les communs dénominateurs.

La société est discriminatoire et ces systèmes, si on n’y prend garde, pourraient perpétuer ou même augmenter ces discriminations.

Il peut aussi y avoir ce qu’on appelle une boucle de rétroaction. Par exemple, des forces policières utilisent ce genre de système pour identifier des quartiers ou des zones plus à risques. Elles vont y mettre plus de policiers… qui vont rapporter plus de crimes. Donc les statistiques vont renforcer les biais du système.

La bonne nouvelle, c’est qu’il y a de la recherche qui se fait pour développer des algorithmes d’apprentissage qui vont minimiser les discriminations. Par contre, il faudra que les gouvernements imposent des règles pour forcer les entreprises à utiliser ces techniques.

Sauver des vies

Il y a aussi de très bonnes nouvelles à l’horizon.

Le domaine médical sera l’un des plus touchés par l’IA : et ça n’est pas une question seulement de sauver de l’argent.

Les médecins sont humains et donc font des erreurs. Or, plus on entraîne des systèmes avec plus de données, et moins ils font d’erreurs. Ils dépassent en précision les meilleurs médecins, qui n’ont tout simplement pas pu voir autant de cas dans leur carrière. Déjà, ils utilisent ces outils afin d’éviter de manquer des éléments importants, comme des cellules cancéreuses difficiles à distinguer dans une image médicale.

En amont pour ce qui est de la recherche en IA, il y a aussi le développement de nouveaux médicaments. En ce moment, l’exploration est un peu aléatoire. C’est basé sur l’intuition du chimiste. On peut faire beaucoup mieux en tirant parti du grand nombre de données (plus que ce qu'un humain aurait le temps de digérer) qui sont accumulées sur des médicaments et autres molécules.

On n’y est pas encore, mais le potentiel est là, tout comme l’analyse plus efficace du dossier médical d’un patient. On s’en va vers des outils qui vont aider les médecins à faire des liens qui auraient été très difficiles à faire autrement, et à suggérer des traitements qui pourraient sauver des vies.

Sur un horizon de dix ans, les chances que le système médical soit complètement transformé sont très grandes, et bien sûr, l'importance de ces progrès pour tout le monde est énorme.

Et je ne suis pas inquiet pour les pertes d’emplois dans le domaine médical : on aura toujours besoin de la compétence et du jugement des professionnels de la santé. Par contre, on a besoin de solidifier les normes sociales (donc des lois et règlements) permettant à la fois de protéger la vie privée (les données des patients ne devraient pas être utilisées contre lui) et d’agréger ces données pour permettre de guérir mieux et plus de gens, grâce à l’IA.

Les solutions sont politiques

Pour tous ces enjeux et ceux à venir, voilà pourquoi la Déclaration de Montréal est importante. Elle a été signée mardi matin à la Société des arts technologiques de Montréal, en présence de quelque 500 personnes.

Cette Déclaration s’est construite sur les bases d’un vaste consensus. Nous sommes allés consulter la population sur internet, dans des librairies, nous avons recueilli puis compilé des commentaires provenant de toutes disciplines. Tout ce processus de cocréation a été mené avec des philosophes, des sociologues, des juristes et des chercheurs en IA, bref, avec toutes les expertises, incluant celles des citoyens.

Il y a eu plusieurs versions de cette Déclaration. Ce travail a eu sa première mouture lors du Forum sur le développement socialement responsable de l’IA, organisé par l’Université de Montréal le 2 novembre 2017.

Ça été le lieu de naissance de cette Déclaration.

Son but est d’asseoir un certain nombre de principes qui seraient la base pour l’adoption de nouvelles règles et lois pour s’assurer que l’IA est développée de manière socialement responsable. Les lois actuelles n’étant pas toujours bien adaptées à ces nouvelles situations.

Et on arrive ici au politique.

Les questions d’éthiques ou d’abus de la technologie, à la fin, deviennent politiques, donc relèvent de décisions collectives.

Comment va-t-on organiser la société ? C’est de la politique.

Que fait-on avec la connaissance ? C’est de la politique.

Je sens une forte volonté des gouvernements provinciaux et fédéral au Canada de s’engager vers un développement socialement responsable. Parce que le Canada est un leader scientifique en IA, il a été un des premiers pays à voir tout son potentiel et le premier à se doter d’un plan national. Il a aussi la volonté de jouer un rôle de leader social. Montréal a été à l’avant-plan depuis deux ans dans cette prise de conscience. Je sens aussi de telles volontés en Europe, comme en France ou en Allemagne.

Règle générale, les scientifiques ont tendance à ne pas vouloir trop se mêler de politique. Mais quand il y a des enjeux qui les concernent et qui vont avoir un grand impact sur la société, ils doivent prendre leur responsabilité et faire partie de la discussion.

Dans ce débat, je me suis rendu compte que la société me prêtait une voix. Que les gouvernements et les médias étaient intéressés à ce que j’avais à dire sur ces sujets à cause de mon rôle de pionnier dans le développement scientifique de l’IA. Donc maintenant, pour moi, c’est plus qu’une responsabilité, ça devient un devoir. Je n’ai pas le choix.

Yoshua Bengio

Article publié sur le site : https://theconversation.com/lia-pour-le-meilleur-sans-le-pire-108275

Dernière modification le mardi, 11 décembre 2018